302.AI est une plate-forme d'applications d'IA payante qui offre les API d'IA et les applications en ligne les plus complètes disponibles.

🥳 Bravo pour la version iOS de NextChat en ligne !

👉 Cliquez ici pour installer maintenant

❤️ Code source à venir

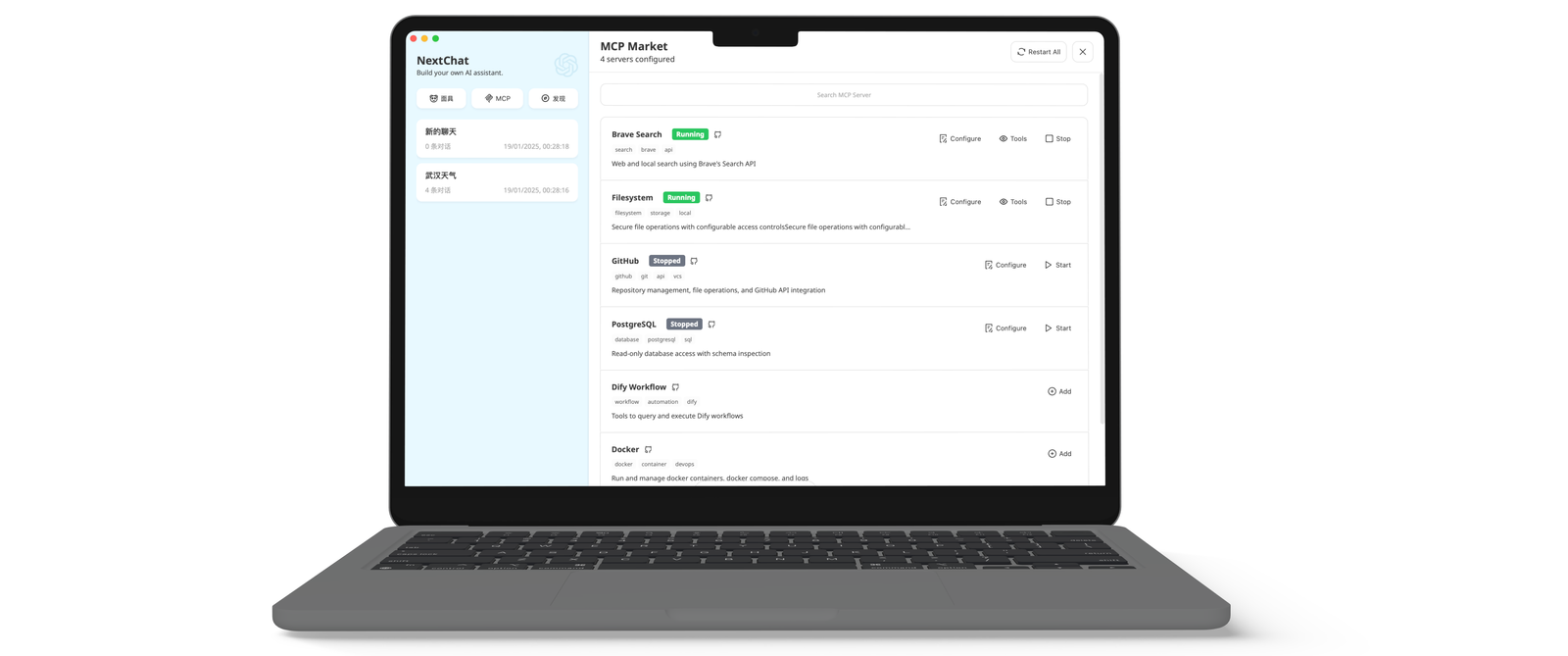

🫣 NextChat Supporte MCP !

Avant la construction, veuillez définir env ENABLE_MCP=true

Répondre aux exigences de privatisation et de déploiement de personnalisation de votre entreprise :

- Personnalisation de la marque: VI/UI sur mesure pour s'aligner parfaitement sur l'image de votre marque d'entreprise.

- Intégration des ressources: Configuration et gestion unifiées de dizaines de ressources d'IA par les administrateurs de l'entreprise, prêtes à être utilisées par les membres de l'équipe.

- Contrôle des autorisations: autorisations de membres, autorisations de ressources et autorisations de base de connaissances clairement définies, toutes contrôlées via un panneau d'administration de niveau entreprise.

- Intégration des connaissances: Combiner votre base de connaissances interne avec des capacités d'IA, la rendant plus pertinente par rapport aux besoins commerciaux spécifiques de votre entreprise par rapport à l'IA générale.

- Audit de sécurité: interceptez automatiquement les demandes sensibles et tracez tous les enregistrements historiques des conversations, garantissant ainsi le respect par l'IA des normes de sécurité des informations de l'entreprise.

- Déploiement privé: Déploiement privé au niveau de l'entreprise prenant en charge diverses solutions de cloud privé grand public, garantissant la sécurité des données et la protection de la confidentialité.

- Mises à jour continues: Mises à jour et mises à niveau continues des capacités de pointe telles que l'IA multimodale, garantissant une innovation et un progrès constants.

Pour les demandes d’entreprises, veuillez contacter : entreprise@nextchat.dev

- Déployez gratuitement en un seul clic sur Vercel en moins d'1 minute

- Client compact (~ 5 Mo) sur Linux/Windows/MacOS, téléchargez-le maintenant

- Entièrement compatible avec les LLM auto-déployés, recommandé pour une utilisation avec RWKV-Runner ou LocalAI

- La confidentialité avant tout, toutes les données sont stockées localement dans le navigateur

- Prise en charge du Markdown : LaTex, sirène, mise en évidence du code, etc.

- Conception réactive, mode sombre et PWA

- Vitesse de chargement rapide du premier écran (~ 100 Ko), prise en charge de la réponse en streaming

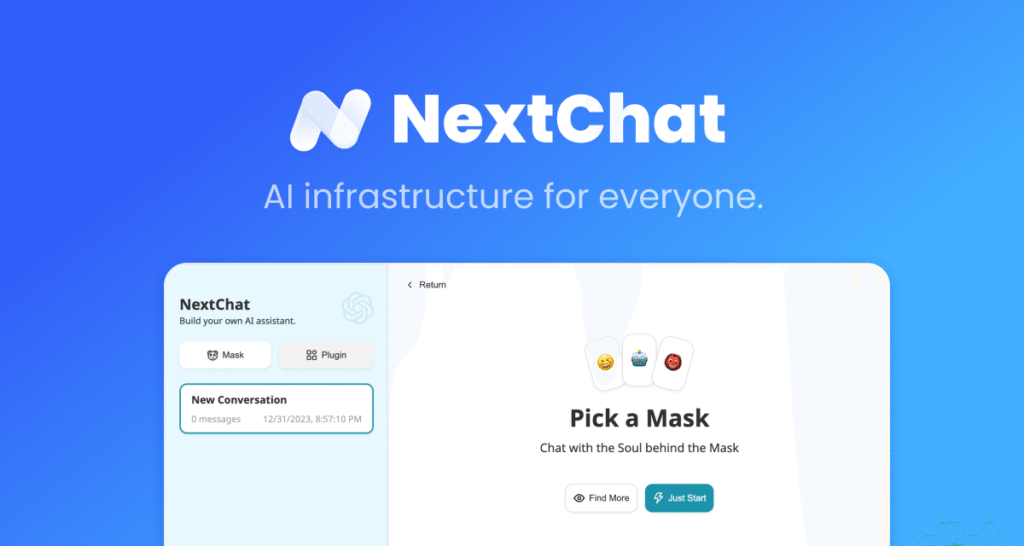

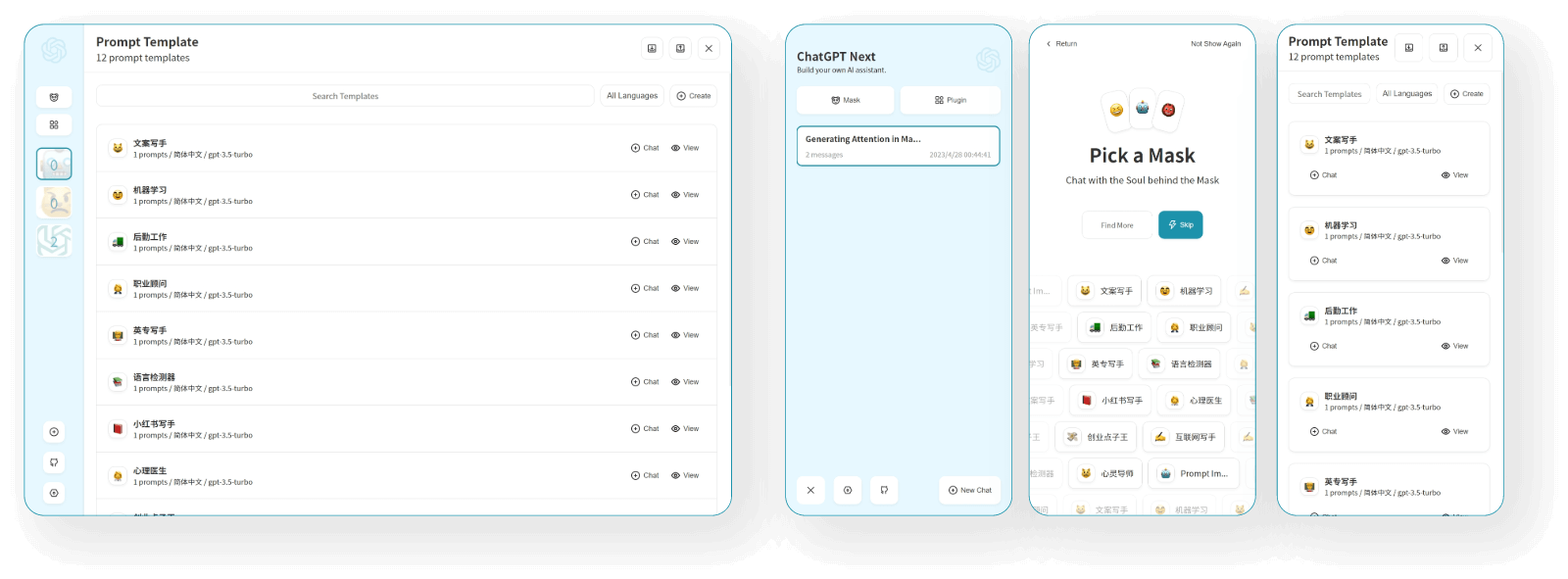

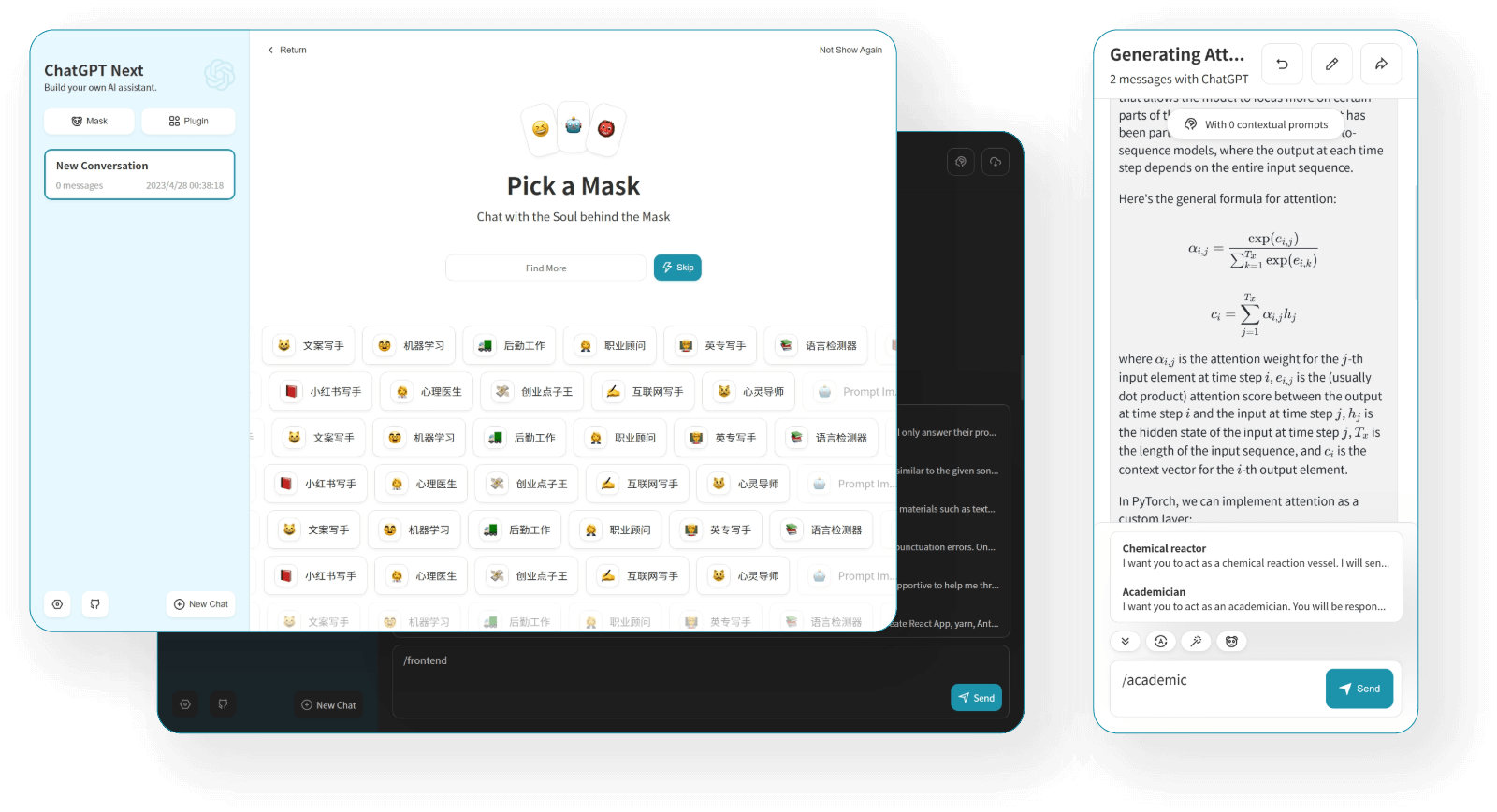

- Nouveau dans la v2 : créez, partagez et déboguez vos outils de chat avec des modèles d'invite (masque)

- Des invites impressionnantes alimentées par Awesome-chatgpt-prompts-zh et Awesome-chatgpt-prompts

- Compresse automatiquement l'historique des discussions pour prendre en charge les longues conversations tout en enregistrant vos jetons

- I18n : anglais, 简体中文, 繁体中文, 日本語, Français, Español, Italiano, Türkçe, Deutsch, Tiếng Việt, Русский, Čeština, 한국어, Indonésie

- 🚀 v2.15.8 prend désormais en charge le chat en temps réel #5672

- 🚀 v2.15.4 L'application prend en charge l'utilisation de l'API Tauri fetch LLM, PLUS DE SÉCURITÉ ! #5379

- 🚀 v2.15.0 prend désormais en charge les plugins ! Lisez ceci : NextChat-Awesome-Plugins

- 🚀 v2.14.0 prend désormais en charge les artefacts et SD

- 🚀 La v2.10.1 prend en charge le modèle Google Gemini Pro.

- 🚀 v2.9.11, vous pouvez utiliser Azure Endpoint maintenant.

- 🚀 v2.8, nous avons maintenant un client qui fonctionne sur toutes les plateformes !

- 🚀 v2.7 partageons les conversations sous forme d'image, ou partageons-les sur ShareGPT !

- 🚀 La v2.0 est sortie, vous pouvez désormais créer des modèles d'invite et transformer vos idées en réalité ! Lisez ceci : Conseils d'ingénierie d'invite ChatGPT : invite de zéro, un et quelques tirs.

- Obtenez la clé API OpenAI ;

- Cliquez

souviens-toi de ça

CODEest le mot de passe de votre page ; - Apprécier 🙂

Français > FAQ

Si vous avez déployé votre propre projet en un seul clic en suivant les étapes ci-dessus, vous pouvez rencontrer le problème des « Mises à jour disponibles » qui apparaissent constamment. En effet, Vercel créera un nouveau projet pour vous par défaut au lieu de bifurquer ce projet, ce qui entraînera l'incapacité de détecter correctement les mises à jour.

Nous vous recommandons de suivre les étapes ci-dessous pour redéployer :

- Supprimez le référentiel d'origine ;

- Utilisez le bouton fork dans le coin supérieur droit de la page pour créer ce projet ;

- Choisissez et déployez à nouveau dans Vercel, veuillez consulter le tutoriel détaillé.

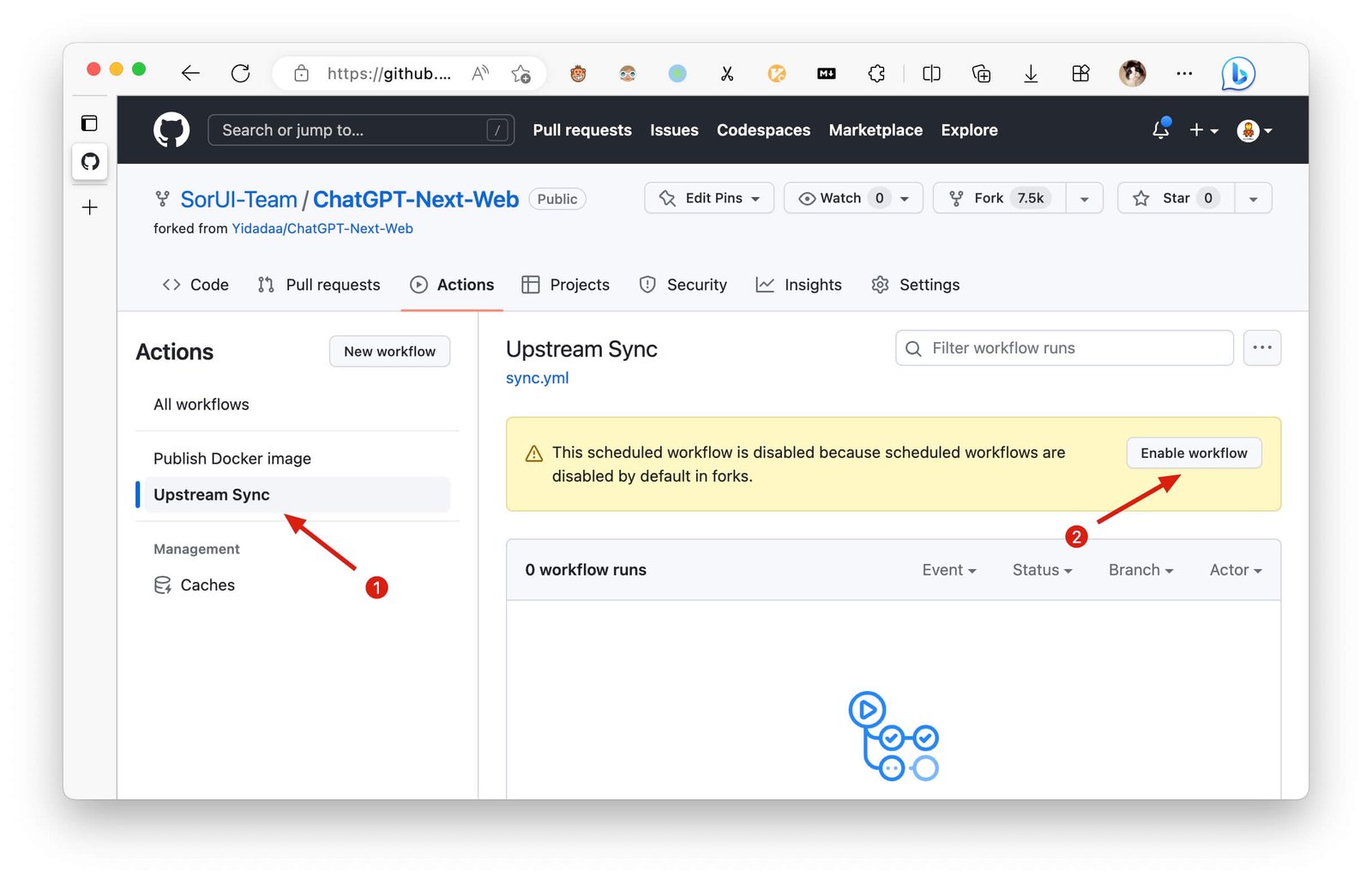

Si vous rencontrez un échec d’exécution de la synchronisation en amont, veuillez mettre à jour manuellement le code.

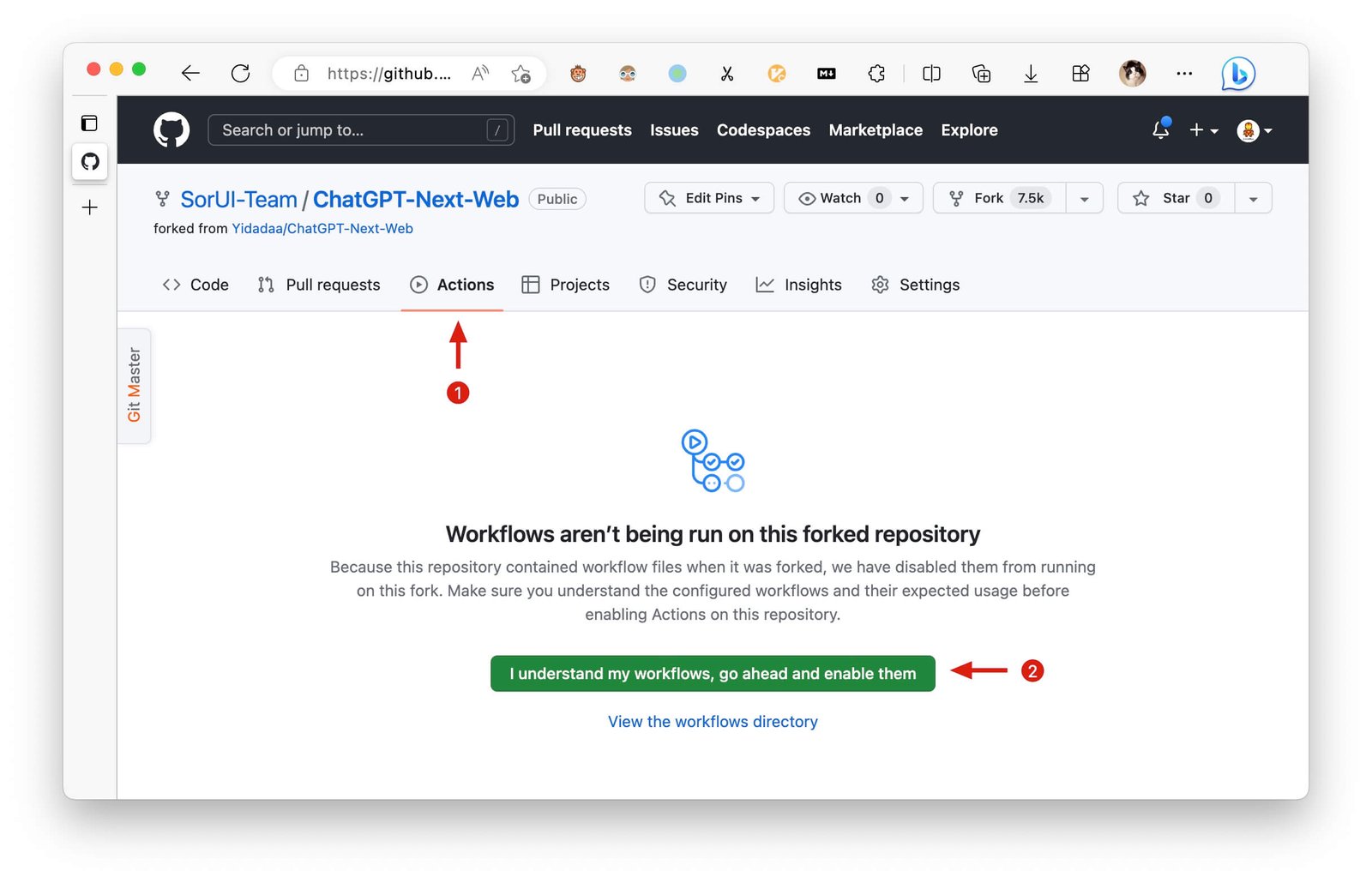

Après avoir bifurqué le projet, en raison des limitations imposées par GitHub, vous devez activer manuellement les flux de travail et l'action de synchronisation en amont sur la page Actions du projet bifurqué. Une fois activées, les mises à jour automatiques seront programmées toutes les heures :

Si vous souhaitez mettre à jour instantanément, vous pouvez consulter la documentation GitHub pour savoir comment synchroniser un projet forké avec le code en amont.

Vous pouvez jouer ou regarder ce projet ou suivre l'auteur pour recevoir des notifications de sortie à temps.

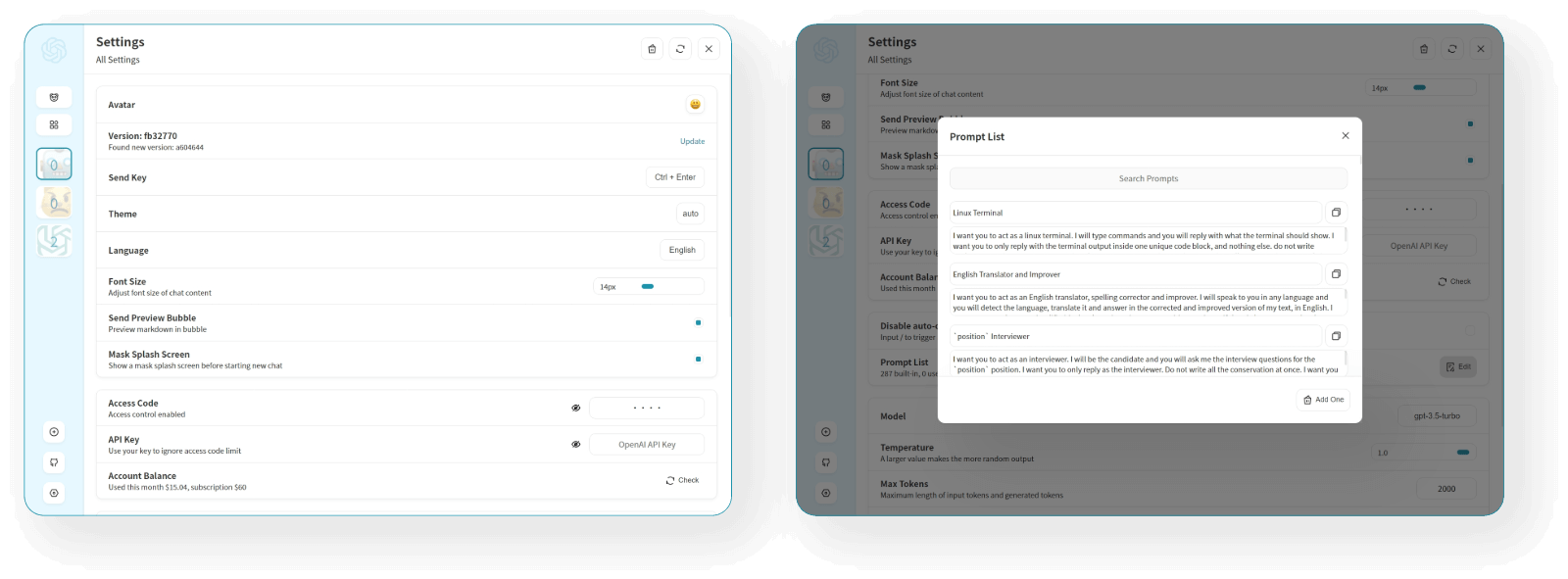

Ce projet offre un contrôle d'accès limité. Veuillez ajouter une variable d'environnement nommée CODE sur la page des variables d'environnement Vercel. La valeur doit être constituée de mots de passe séparés par des virgules comme ceci :

Après avoir ajouté ou modifié cette variable d'environnement, veuillez redéployer le projet pour que les modifications prennent effet.

Mot de passe d'accès, séparé par une virgule.

OPENAI_API_KEY (requis)

Votre clé API openai, joignez plusieurs clés API avec une virgule.

Défaut:

https://api.openai.com

Exemples :

http://your-openai-proxy.com

Remplacez l’URL de base de la demande d’API openai.

Spécifiez l’ID de l’organisation OpenAI.

Exemple : https://{azure-resource-url}/openai

URL de déploiement Azure.

Clé API Azure.

AZURE_API_VERSION (facultatif)

Version Azure Api, recherchez-la dans la documentation Azure.

GOOGLE_API_KEY (facultatif)

Clé API Google Gemini Pro.

URL de l’API Google Gemini Pro.

ANTHROPIC_API_KEY (facultatif)

anthropique Claude Api Key.

ANTHROPIC_API_VERSION (facultatif)

Claude anthropique version Api.

anthropique claude Api Url.

Clé de feu Baidu.

BAIDU_SECRET_KEY (facultatif)

Clé secrète Baidu.

URL du feu Baidu.

BYTEDANCE_API_KEY (facultatif)

Clé API ByteDance.

URL de l’API ByteDance.

ALIBABA_API_KEY (facultatif)

Clé API Alibaba Cloud.

URL de l’API Alibaba Cloud.

URL de l'API iflytek.

IFLYTEK_API_KEY (Facultatif)

Clé API iflytek.

IFLYTEK_API_SECRET (Facultatif)

iflytek Api Secret.

CHATGLM_API_KEY (facultatif)

Clé API ChatGLM.

URL de l'API ChatGLM.

DEEPSEEK_API_KEY (facultatif)

Clé API DeepSeek.

URL de l’API DeepSeek.

HIDE_USER_API_KEY (facultatif)

Par défaut : vide

Si vous ne souhaitez pas que les utilisateurs saisissent leur propre clé API, définissez cette valeur sur 1.

Par défaut : vide

Si vous ne souhaitez pas que les utilisateurs utilisent GPT-4, définissez cette valeur sur 1.

ENABLE_BALANCE_QUERY (facultatif)

Par défaut : vide

Si vous souhaitez que les utilisateurs interrogent le solde, définissez cette valeur sur 1.

DISABLE_FAST_LINK (facultatif)

Par défaut : vide

Si vous souhaitez désactiver les paramètres d'analyse de l'URL, définissez-le sur 1.

Valeur par défaut : vide Exemple :

+llama,+claude-2,-gpt-3.5-turbo,gpt-4-1106-preview=gpt-4-turbosignifie ajouterllama, claude-2à la liste des modèles et supprimezgpt-3.5-turboà partir de la liste et affichergpt-4-1106-previewcommegpt-4-turbo.

Pour contrôler les modèles personnalisés, utilisez + pour ajouter un modèle personnalisé, utilisez - pour masquer un modèle, utilisez name=displayName pour personnaliser le nom du modèle, séparé par une virgule.

Utilisateur -all pour désactiver tous les modèles par défaut, +all pour activer tous les modèles par défaut.

Pour Azure : utilisez modelName@Azure=deploymentName pour personnaliser le nom du modèle et le nom du déploiement.

Exemple:

+gpt-3.5-turbo@Azure=gpt35affichera l'optiongpt35(Azure)dans la liste des modèles. Si vous ne pouvez utiliser que le modèle Azure,-all,+gpt-3.5-turbo@Azure=gpt35volontégpt35(Azure)la seule option dans la liste des modèles.

Pour ByteDance : utilisez modelName@bytedance=deploymentName pour personnaliser le nom du modèle et le nom du déploiement.

Exemple:

+Doubao-lite-4k@bytedance=ep-xxxxx-xxxaffichera l'optionDoubao-lite-4k(ByteDance)dans la liste des modèles.

DEFAULT_MODEL (facultatif)

Changer le modèle par défaut

Valeur par défaut : vide Exemple :

gpt-4-vision,claude-3-opus,my-custom-modelsignifie ajouter des capacités de vision à ces modèles en plus des correspondances de modèles par défaut (qui détectent les modèles contenant des mots-clés comme « vision », « claude-3 », « gemini-1.5 », etc.).

Ajoutez des modèles supplémentaires pour disposer de capacités de vision, au-delà de la correspondance de modèles par défaut. Plusieurs modèles doivent être séparés par des virgules.

WHITE_WEBDAV_ENDPOINTS (facultatif)

Vous pouvez utiliser cette option si vous souhaitez augmenter le nombre d'adresses de service webdav auxquelles vous êtes autorisé à accéder, comme l'exige le format:

- Chaque adresse doit être un point de terminaison complet

https://xxxx/yyy - Plusieurs adresses sont reliées par ', '

DEFAULT_INPUT_TEMPLATE (facultatif)

Personnalisez le modèle par défaut utilisé pour initialiser l'élément de configuration Prétraitement des entrées utilisateur dans Paramètres.

STABILITY_API_KEY (facultatif)

Clé API de stabilité.

Personnalisez l’URL de l’API de stabilité.

Activer la fonctionnalité MCP (Protocole de contexte du modèle)

SILICONFLOW_API_KEY (facultatif)

Clé API SiliconFlow.

SILICONFLOW_URL (facultatif)

URL de l'API SiliconFlow.

302. Clé API AI.

302.URL de l'API AI.

NodeJS >= 18, Docker >= 20

Avant de commencer le développement, vous devez créer un nouveau .env.local à la racine du projet et placez-y votre clé API :

OPENAI_API_KEY=

# if you are not able to access openai service, use this BASE_URL

BASE_URL=https://chatgpt1.nextweb.fun/api/proxy

# 1. install nodejs and yarn first

# 2. config local env vars in `.env.local`

# 3. run

yarn install

yarn dev

docker pull yidadaa/chatgpt-next-web

docker run -d -p 3000:3000 \

-e OPENAI_API_KEY=sk-xxxx \

-e CODE=your-password \

yidadaa/chatgpt-next-web

Vous pouvez démarrer le service derrière un proxy :

docker run -d -p 3000:3000 \

-e OPENAI_API_KEY=sk-xxxx \

-e CODE=your-password \

-e PROXY_URL=http://localhost:7890 \

yidadaa/chatgpt-next-web

Si votre proxy a besoin d'un mot de passe, utilisez :

-e PROXY_URL="http://127.0.0.1:7890 user pass"

Si vous activez MCP, utilisez:

docker run -d -p 3000:3000 \

-e OPENAI_API_KEY=sk-xxxx \

-e CODE=your-password \

-e ENABLE_MCP=true \

yidadaa/chatgpt-next-web

bash <(curl -s https://raw.githubusercontent.com/Yidadaa/ChatGPT-Next-Web/main/scripts/setup.sh)

Synchronisation des enregistrements de discussion (UpStash)

| 简体中文| Anglais | Italien | 日本语| 한국어

Veuillez vous rendre au [docs][./docs] répertoire pour plus d’instructions de documentation.

Si vous souhaitez ajouter une nouvelle traduction, lisez ce document.

Achetez-moi un café

AVEC